ساخت فایل Robots.txt با روشهای ساده

آیا میدانید فایل robots.txt چیست و چگونه میتوان با کمک آن سئوی سایت را بهبود داد؟ فایل robots.txt یکی از ابزارهای مهم و ضروری در بهینهسازی سایت برای موتورهای جستجو است. این فایل به موتورهای جستجو میگوید که چگونه وبسایت شما را مورد بررسی قرار دهند و کدام صفحات را خزش کنند یا نکنند.

این موضوع باعث میشود که فایل robots.txt به یکی از ابزارهای بسیار موثر در سئو تبدیل شود. با استفاده مناسب از این فایل، میتوانید به شکل چشمگیری بهبود عملکرد سئوی سایت خود را تجربه کنید.

در این مقاله، نحوه ساخت فایل robots.txt را برای سایتهای وردپرسی به شما آموزش میدهیم و نشان میدهیم که چگونه میتوانید از این فایل برای بهبود سئوی سایت خود بهره ببرید. پس تا انتهای مقاله همراه ژاکت آکادمی باشید.

فهرست محتوا

فایل Robots.txt چیست؟

فایل robots.txt یک فایل متنی است که کراول و ایندکس کردن صفحات سایت را برای رباتهای موتور جستجو مشخص میکند. به طور کلی، این فایل به رباتهای موتور جستجو دستور میدهد که چه صفحاتی را کراول کنند یا نکنند.

فایل robots.txt بخشی از پروتکل Robots Exclusion Protocol (REP) است که شامل دستورالعملهایی برای مدیریت دسترسی رباتها به صفحات وب است. لینکهای فالو و نوفالو نیز جزئی از همین پروتکل هستند.

در ویدیو زیر توضیحات ضروری درمورد ساخت فایل Robots.txt به همراه نکاتی برای بهینهسازی آن را به شما گفتهایم:

آموزش ساخت فایل Robots.txt

برای ساخت فایل robots.txt لازم است که بدانیم این فایل از چهار دستور اصلی پشتیبانی میکند:

- User-agent: در این بخش، ربات یا رباتهایی که دستورات برای آنها نوشته شده را مشخص میکنید. مثلاً: User-agent: googlebot یعنی تنها رباتهای موتور جستجو گوگل از دستورات فایل ربات باید پیروی کنند. اگر بخواهید که تمامی رباتهای موتورهای جستجو شامل شوند، کافیست در جلوی User-agent: علامت * را قرار دهید.

- Disallow: این دستور به ربات میگوید که اجازه ندارد به بخشهای مشخص شده از سایت دسترسی پیدا کند. کافیست که نشانی صفحه مدنظر خود را در جلوی آن قرار دهید.

- Allow: این دستور به ربات اجازه میدهد که به بخشهای خاصی از سایت دسترسی پیدا کند، حتی اگر آن بخشها در دستور Disallow قرار گرفته باشند اولویت با دستوری Allow است و رباتهای موتور جستجو ابتدا از این دستور پیروی میکنند.

- Sitemap: این دستور برای اعلام آدرس نقشه سایت به رباتهای موتور جستجو استفاده میشود.

چگونه برای سایتم فایل Robots.txt بسازم؟

برای ساخت فایل robots.txt، دو روش اصلی وجود دارد که بر اساس نوع سایتتان که یا وردپرسی است و یا اختصاصی میتوانید یکی از آنها را انتخاب کنید:

- استفاده از افزونه برای سایتهای وردپرسی

- ساخت فایل robots txt بصورت دستی برای سایتهای کدنویسی

ساخت فایل روبوتس با افزونه وردپرس

در سایتهای وردپرس با استفاده از افزونههای مختلف میتوانید به راحتی فایل robots.txt را ایجاد و مدیریت کنید. این افزونهها به شما امکان میدهند تا دستورات مورد نظر خود را به سادگی وارد کرده و فایل را مستقیماً از پنل مدیریت وردپرس ویرایش کنید.

افزونه All in One SEO (AIOSEO) با بیش از 2 میلیون نصب فعال، یکی از محبوبترین افزونهها برای سئو و بهینهسازی وبسایتهای وردپرسی است. این افزونه به دلیل طراحی کاربرپسند و آسان خود، گزینهای عالی برای مبتدیان به شمار میآید. با استفاده از AIOSEO، میتوانید به راحتی فایل robots.txt خود را ایجاد و ویرایش کنید. در ادامه نحوه انجام این کار توضیح داده میشود.

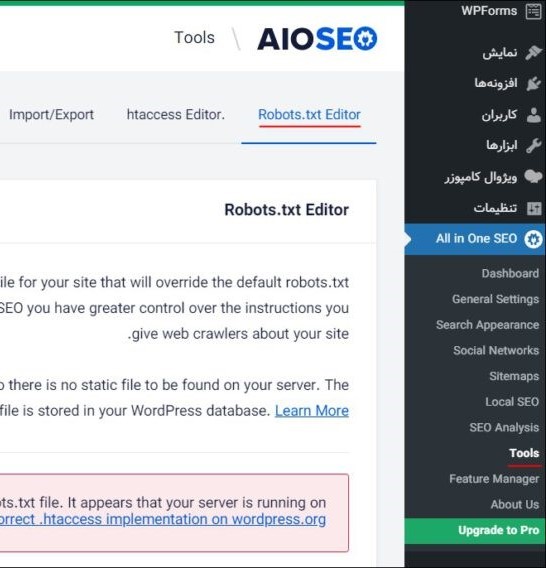

1. نصب و فعالسازی افزونه: ابتدا افزونه All in One SEO را از مخزن وردپرس نصب و فعال کنید. پس از فعالسازی، از منوی All in One SEO گزینه Tools را انتخاب کنید تا به صفحه ابزارها دسترسی پیدا کنید.

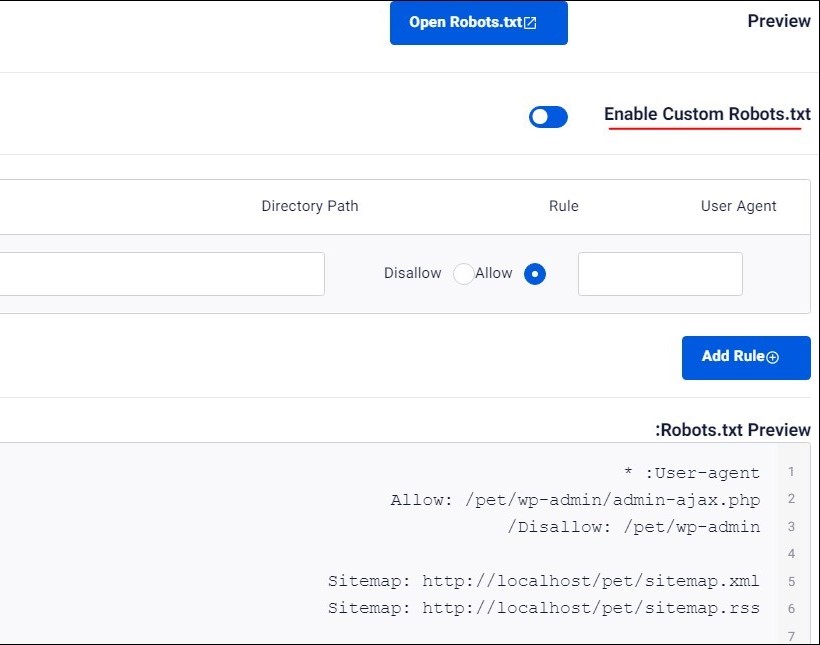

2. فعال کردن گزینه Custom Robots.txt: در این صفحه، گزینه Enable Custom Robots.txt را فعال کنید. با فعال کردن این گزینه، یک فایل سفارشی robots.txt در وردپرس ایجاد میشود که میتوانید آن را ویرایش کنید.

3. مشاهده فایل Robots.txt موجود: افزونه AIOSEO فایل robots.txt موجود را در بخش Robots.txt Preview در پایین صفحه نمایش میدهد. این بخش شامل قوانین پیشفرضی است که توسط وردپرس اضافه شدهاند و به موتورهای جستجو دستور میدهد که از فایلهای اصلی وردپرس استفاده نکنند، اجازه ایندکس کردن تمام مطالب را بدهند و به نقشههای XML سایت دسترسی داشته باشند.

4. افزودن قوانین سفارشی: برای افزودن قوانین جدید، دکمه Add Rule را انتخاب کنید. سپس، در قسمت “User Agent”، عامل کاربری مورد نظر خود را وارد کنید. اگر میخواهید قانون برای همه رباتها اعمال شود، از علامت * استفاده کنید.در قسمت Rule، مشخص کنید که آیا میخواهید دسترسی به بخش مشخصی از سایت مجاز یا غیرمجاز باشد. سپس نام فایل یا مسیر دایرکتوری را در قسمت Directory Path وارد کنید.

5. ذخیره تنظیمات: پس از وارد کردن قوانین، برای ذخیره تنظیمات روی دکمه Save Changes کلیک کنید.

این مراحل به شما کمک میکند تا فایل robots.txt سایت وردپرسی خود را به راحتی ایجاد و مدیریت کنید و کنترل بیشتری بر روی نحوه خزش و ایندکسشدن صفحات سایت توسط موتورهای جستجو داشته باشید.

ساخت و یا ویرایش فایل Robots نیازمند داشتن دانش سئو و بهینه سازی وبسایت است. با شرکت در دوره سئو پیشرفته ژاکت آکادمی علاوه بر مباحث سئو داخلی و خارجی، اصول سئو تکنیکال را یاد بگیرید و به راحتی خودتان Robots.txt را برای سایتتان به بهترین شکل بسازید و یا ادیت کنید. هم اکنون این دوره کامل را با 50% تخفیف ویژه دریافت نمایید.

ساخت فایل Robots.txt برای سایتهای کدنویسی و اختصاصی

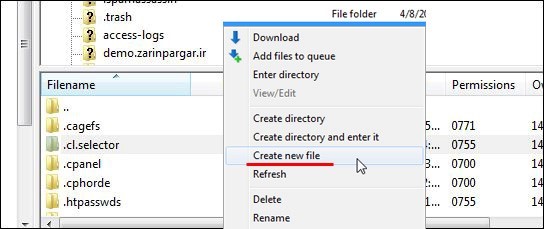

اگر سایت شما اختصاصی و کدنویسی باشد، شما باید فایل robots.txt را به صورت دستی ایجاد کنید و سپس آن را در دایرکتوری اصلی سایت خود آپلود کنید. برای این کار در دایرکتوری اصلی وبسایت خود راستکلیک کرده و گزینه “Create new file” را انتخاب کنید. سپس نام فایل را به robots.txt تغییر دهید.

اگر فایل موجود باشد میتوانید از طریق سیپنل یا دایرکت ادمین هاست یا با استفاده از FTP به هاست خود متصل شوید و فایل robots.txt را ویرایش و سفارشیسازی کنید. در اینجا نحوه انجام این کار با استفاده از FTP توضیح داده شده است:

- اتصال به هاست با استفاده از FTP: ابتدا از طریق یک کلاینت FTP مانند FileZilla به هاست خود متصل شوید.

- پیدا کردن فایل Robots.txt: پس از ورود به هاست، به دایرکتوری اصلی وبسایت خود (پوشه public_html) بروید و فایل robots.txt را پیدا کنید.

- ویرایش فایل Robots.txt: فایل robots.txt را باز کرده و دستورات مورد نظر خود را وارد کنید. برای مثال:

* :User-agent

Disallow: /basket

Allow: /products

Sitemap: https://www.example.com/sitemap.xml - ذخیره تغییرات: پس از ویرایش فایل، آن را ذخیره کنید و مطمئن شوید که تغییرات اعمال شدهاند.

این روش به شما امکان میدهد تا کنترل کاملی بر نحوه دسترسی رباتهای موتور جستجو به محتوای سایت خود داشته باشید و میتوانید فایل robots.txt خود را به دلخواه حتی در سایتهای غیر وردپرسی سفارشیسازی کنید.

نمونهای از فایل robots.txt بهینه برای سئو

در زیر نمونهای از یک فایل robots.txt بهینهشده برای سئو یک سایت وردپرسی را نشان میدهد. در این فایل، بخشهای مختلفی مانند User-agent، Disallow، و Allow وجود دارد که هر کدام دستورالعملهای خاصی را به موتورهای جستجو میدهند.

ساخت فایل robots.txt بهینه یکی از اولین و سادهترین کارهایی است که میتوانید برای بهبود سئوی فنی سایت خود انجام دهید. با محدود کردن دسترسی به صفحات غیرمهم و هدایت موتورهای جستجو به سمت صفحات مهم، میتوانید بودجه خزش خود را کنترل و مدیریت کنید.

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Sitemap: https://example.com/sitemap_index.xml

نتیجهگیری

ساخت و بهینهسازی فایل robots.txt به موتورهای جستجو کمک میکند تا به جای صرف زمان و منابع روی صفحات غیرضروری یا تکراری، تمرکز خود را روی محتوای ارزشمند سایت شما بگذارند. این کار نه تنها بودجه خزش سایت را مدیریت میکند، بلکه به بهبود رتبه صفحات مهم سایت شما در نتایج جستجو کمک میکند.

در این مقاله با یکدیگر بررسی کردیم که فایل ربات چیست، چگونه میتوان فایل robots.txt را ساخت و همچنین دستورهای حیاتی و مهم آن را با یکدیگر بررسی کردیم تا بتوانید در هنگام ساخت این فایل مهم برای وبسایت آن را برای سئو سایت خود نیز بهینهسازی کنید.

سوالات متداول

robots.txt چیست؟

- robots.txt یک فایل با فرمت txt است که در داخل روت یا ریشه وبسایت بارگزاری میشود و شامل دستوراتی است که به رباتهای موتورهای جستجو اجازه میدهد که چه صفحات یا فایلهایی را ایندکس و چه فایل و صفحاتی را ایندکس نکنند.

فایل robots.txt کجاست؟

- برای دسترسی به این فایل کافی است به سی پنل یا دایرکت ادمین سایت خود بروید و وارد پوشه public_html شوید. این پوشه همان روت یا ریشه سایت شماست. در آنجا فایل robots.txt را مشاهده خواهید کرد.

چرا فایل robots.txt را باید برای سئو بهینه سازی کرد؟

- فایل robots.txt یک ابزار کلیدی در بهینهسازی موتورهای جستجو (SEO) است که به شما اجازه میدهد کنترل دقیقی بر نحوه خزش و ایندکس شدن صفحات سایتتان داشته باشید. و از موارد آسیب رسان به سئو سایتتان مانند کنیبالیزیشن جلوگیری کنید.

مطالب زیر را حتما مطالعه کنید

چگونه از هوش مصنوعی استفاده کنیم؟

مشکل کپی رایت موزیک در اینستاگرام را چگونه حل کنیم؟

صفر تا صد گوگل ترند چیست به زبان ساده و نحوه کاربرد آن در سئو

دارک وب چیست؟ رازهای ورود و کارهای پرخطر دنیای دارک وب

Moz چیست و چگونه به سئوی سایت شما کمک میکند؟

ایده های ناب بلاگری بدون چهره

4 دیدگاه

به گفتگوی ما بپیوندید و دیدگاه خود را با ما در میان بگذارید.

افزونه دیگه ای هم هست که بتونم باهاش ساخت فایل robots.txt رو انجام بدم؟

بله. میتونید از افزونه یوست سئو و یا رنک مث استفاده کنید.

فایل ربات حتما باید فرمتش txt باشه؟ مثه سایت مپ نمیشه فرمت دیگه ای گذاشت داخل روت سایت؟؟

کاربر عزیز، فایل robots حتما باید با فرمت txt داخل روت سایت آپلود بشه.